W ostatnich latach świat telefonów komórkowych przeszedł ogromne zmiany. Zasadnicze różnice widzimy praktycznie we wszystkich aspektach, niezależnie od tego, czy skupimy się na rozmiarze, czy designie, wydajności czy innych inteligentnych funkcjach. Jakość aparatów fotograficznych odgrywa obecnie stosunkowo dużą rolę. Na ten moment można powiedzieć, że to jeden z najważniejszych aspektów smartfonów, w którym flagowce nieustannie ze sobą rywalizują. Poza tym, porównując np. telefony z Androidem i iPhone’a Apple’a, znajdziemy szereg ciekawych różnic.

Mogłoby być interesują Cię

Jeśli interesujesz się światem technologii mobilnych, to na pewno wiesz, że jedną z największych różnic można doszukać się w przypadku rozdzielczości sensora. O ile Androidy często oferują obiektyw o rozdzielczości większej niż 50 Mpx, o tyle iPhone od lat stawia jedynie na 12 Mpx i wciąż może oferować zdjęcia lepszej jakości. Niewiele uwagi poświęca się jednak układom ogniskowania obrazu, gdzie napotykamy dość interesującą różnicę. Konkurencyjne telefony z systemem operacyjnym Android często (częściowo) opierają się na tzw. laserowym autofokusie, natomiast smartfony z logiem nadgryzionego jabłka nie posiadają tej technologii. Jak to właściwie działa, po co się go stosuje i na jakich technologiach opiera się Apple?

Ostrość laserowa vs iPhone

Wspomniana technologia ogniskowania laserowego działa dość prosto, a jej zastosowanie ma duży sens. W tym przypadku w fotomodule ukryta jest dioda, która po naciśnięciu spustu emituje promieniowanie. W tym przypadku wysyłana jest wiązka, która odbija się od fotografowanego obiektu/przedmiotu i powraca, a czas ten można wykorzystać do szybkiego obliczenia odległości za pomocą algorytmów oprogramowania. Niestety ma to też swoją ciemną stronę. Podczas robienia zdjęć na większe odległości ogniskowanie lasera nie jest już tak dokładne, a także podczas robienia zdjęć przezroczystych obiektów i niekorzystnych przeszkód, które nie mogą niezawodnie odbijać wiązki światła. Z tego powodu większość telefonów nadal korzysta ze sprawdzonego algorytmu wykrywania kontrastu sceny. Czujnik z takim czujnikiem potrafi znaleźć idealny obraz. Połączenie sprawdza się bardzo dobrze i zapewnia szybkie i dokładne ustawianie ostrości obrazu. Na przykład popularny Google Pixel 6 ma ten system (LDAF).

Z drugiej strony mamy iPhone'a, który działa trochę inaczej. Ale w rdzeniu jest całkiem podobnie. Po naciśnięciu spustu kluczową rolę odgrywa komponent ISP, czyli Image Signal Processor, który został znacząco ulepszony w ostatnich latach. Układ ten wykorzystuje metodę kontrastu i zaawansowane algorytmy, aby natychmiast ocenić najlepszą ostrość i wykonać zdjęcie wysokiej jakości. Oczywiście na podstawie uzyskanych danych trzeba mechanicznie przesunąć obiektyw w żądane położenie, ale wszystkie aparaty w telefonach komórkowych działają w ten sam sposób. Choć sterowane są za pomocą „silnika”, ich ruch nie jest obrotowy, lecz liniowy.

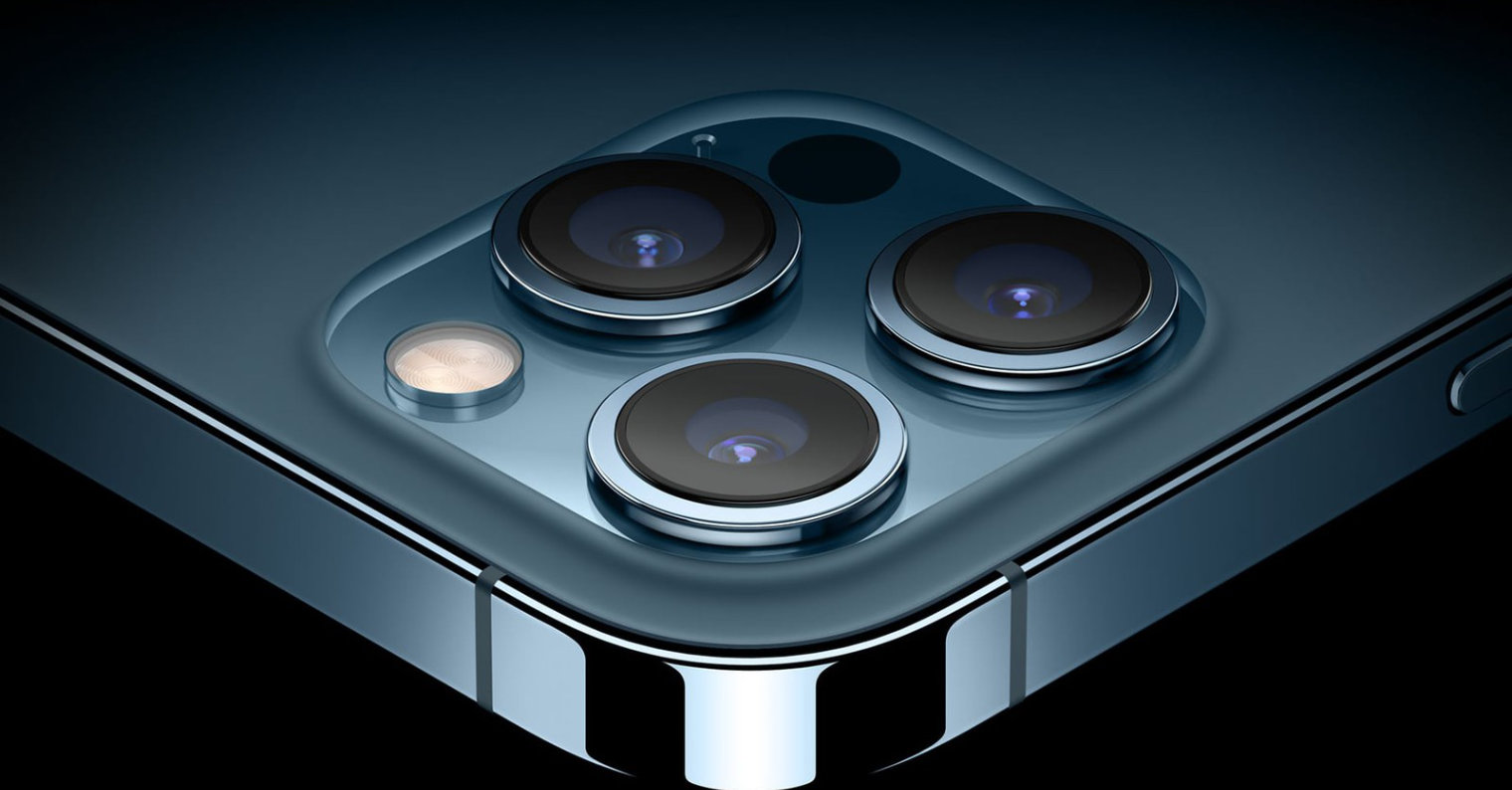

O krok przed nami są modele iPhone 12 Pro (Max) i iPhone 13 Pro (Max). Jak można się domyślić, modele te wyposażone są w tzw. skaner LiDAR, który potrafi błyskawicznie określić odległość od fotografowanego obiektu i wykorzystać tę wiedzę na swoją korzyść. Tak naprawdę technologia ta jest bliska wspomnianemu skupieniu lasera. LiDAR potrafi wykorzystać promienie lasera do stworzenia modelu 3D swojego otoczenia, dlatego wykorzystuje się go głównie do skanowania pomieszczeń, pojazdów autonomicznych oraz do wykonywania zdjęć, przede wszystkim portretów.

Mogłoby być interesują Cię

Adam Kosi

Adam Kosi

Latanie dookoła świata z Apple

Latanie dookoła świata z Apple